Hoy está de moda hablar de la Inteligencia Artificial como algo equivalente a la inteligencia que poseemos los seres humanos. Así, nos encontramos con algunos titulares que hablan de los robots dotados de inteligencia artificial como el próximo estadio evolutivo de la humanidad; se habla de derechos de los robots, de robots dotados de emociones, máquinas que han superado el test de Turing, máquinas que son capaces de aprender, etc. Los avances de las tecnologías de la información son muy importantes, hasta el extremo que hay un fuerte consenso acerca de que hemos empezado una nueva era, que podemos denominar , la Edad Digital.

Sin embargo, una reflexión más cuidadosa, nos permitirá entender, por un lado, los límites de la inteligencia artificial tal como la conocemos hoy, y también las oportunidades y amenazas que supone la nueva Edad Digital en la que estamos entrando.

Acuarela de Alan Turing generada mediante inteligencia artificial, considerado el padre de la misma. (Fuente Wikipedia)

¿En qué consiste la inteligencia artificial?

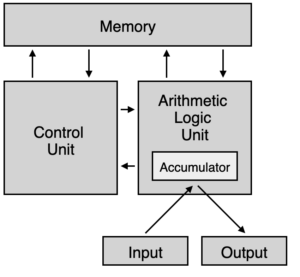

Todos los procesos que catalogamos como inteligencia artificial, se ejecutan sobre redes de ordenadores que son máquinas cuyo diseño está basado en la misma arquitectura, denominada arquitectura de von Neumann o de Princeton, o en evoluciones de la misma, como las arquitecturas de Harvard o de Harvard modificadas. John von Neumann, en el marco del proyecto Manhattan, publicó en 1945 el conocido artículo «First draft of the report on the EDVAC» , que sentó las bases de la computación digital al introducir el concepto de programa almacenado.

Diagrama de la Arquitectura de von Neumann ( Chris-martin, Aeroid. Fuente Wikipedia)

Este concepto está en el origen de toda la industria del software, ya que es el que permite desacoplar la lógica de los programas de la lógica implementada en el hardware; el incremento de la potencia de proceso y almacenamiento de los computadores ha permitido a su vez el desarrollo de programas cada vez más complejos, constituyéndose en la condición de posibilidad para la revolución digital.

Si bien el concepto de programa almacenado es original de von Neumann, la fundamentación lógica de su arquitectura se puede encontrar en el concepto de máquina universal de Turing, que fue presentado por Alan Turing en 1936 y que consiste en la definición conceptual de una máquina capaz de computar cualquier algoritmo ; esta máquina estaba a su vez basada en el concepto de autómatas deterministas finitos. Alan Turing era estudiante de doctorado en Princeton bajo la dirección de Alonzo Church, cuando presentó su artículo denominado «On Computable Numbers, with an Application to the Entscheidungsproblem».

¿Cuáles son los límites de la inteligencia artificial?

Para comprender los límites de la inteligencia artificial, debemos remontarnos al año 1900, que supuso la entrada en el siglo XX. En agosto de este año se celebró el Congreso Internacional de Matemáticos en la Sorbona, en París; en medio de un ambiente eufórico, cargado de fe en el progreso de la Humanidad, el célebre matemático David Hilbert presentó una ponencia donde planteaba los 23 problemas matemáticos que deberían resolverse en el nuevo siglo.

El segundo problema de Hilbert plantea encontrar una demostración de la consistencia de la aritmética a partir de sus axiomas y las leyes de la lógica. En 1931, Kurt Gödel resolvió de manera inesperada el segundo problema de Hilbert, al demostrar su famoso teorema de incompletitud, según el cual , no es posible demostrar que la aritmética sea a la vez consistente y completa; esto supuso un golpe mortal para todos los programas logicistas.

Representación artística de una máquina de Turing ( fuente Wikipedia)

En 1928 Hilbert formuló el problema conocido como “Entscheidungsproblem”, o problema de la decisión, que consiste en preguntarnos si para una proposición lógica cualquiera existe un algoritmo tal, que para un conjunto de axiomas dados y la lógica de predicados de primer orden, sea capaz de decidir si la proposición es o no es un teorema deducible desde ese sistema de axiomas.

En 1936, el americano Alonzo Church y, poco después el inglés Alan Turing demostraron que el problema de la decisión era indecidible, es decir, no existe ningún algoritmo que sea capaz de establecer si una proposición es o no un teorema en un sistema axiomático; esta conclusión está en la misma línea que el teorema de incompletitud de Gödel. Para realizar sus demostraciones, Church desarrolló el denominado cálculo lambda, y Turing, definió un modelo de computación universal basado en autómatas finitos; ambos sistemas se demostraron como lógicamente equivalentes, y constituyeron la base para el desarrollo de las modernas computadoras.

La forma en la que Alan Turing resolvió el problema de la decisión se conoce como el “problema de la parada”. Lo que Turing demostró fue que no es posible construir un algoritmo sobre su máquina universal que dé respuesta al problema de la decisión en un tiempo finito, es decir, que exista un algoritmo que dé respuesta al problema de la decisión y que además el algoritmo se pare en un tiempo finito de computación. A partir de estos conceptos desarrollamos la distinción entre problemas computables, es decir, para los que existe un algoritmo que finaliza en un tiempo finito, y problemas no computables, en cuyo caso la máquina no se para nunca y no es capaz de dar una respuesta.

En resumen, la inteligencia artificial está limitada en primer lugar, a lo que se puede hacer con funciones computables, y en segundo lugar, es determinista, es decir, no tiene ninguna capacidad de creación que no esté previamente incorporada en su programa.

¿Es el ser humano reductible a una máquina de Turing?

El conocido físico Roger Penrose en su celebrada obra «La nueva mente del emperador» afirmó que la mente humana tiene capacidades no algorítmicas. En concreto, desarrolla la tesis de que esas capacidades no algorítmicas están relacionadas con la consciencia; de alguna manera, la consciencia entra en juego cuando es necesario formular nuevos juicios, o aprender nuevos conceptos, comprender situaciones desconocidas o hacer valoraciones artísticas. Aunque los partidarios de la IA fuerte consideran que las capacidades de la consciencia se pueden implementar en estructuras algorítmicas más abstractas, lo cierto es que no se ha conseguido ningún avance significativo en esta dirección.

El argumento de la habitación china de Searle abunda en la idea de que la complejidad de un proceso algorítmico no le dota de consciencia: supongamos que hemos sido capaces de crear un algoritmo que traduce cualquier sentencia de chino al inglés; podríamos sustituir el algoritmo por una habitación cerrada con una persona que siguiera las instrucciones del algoritmo…..¿entendería chino la persona que siguiendo el algoritmo tradujera las sentencias del chino al inglés? La respuesta obvia es que no. La razón es que los algoritmos operan a un nivel sintáctico, mientras que el ser humano, en sus procesos de comprensión del lenguaje operan a un nivel semántico.

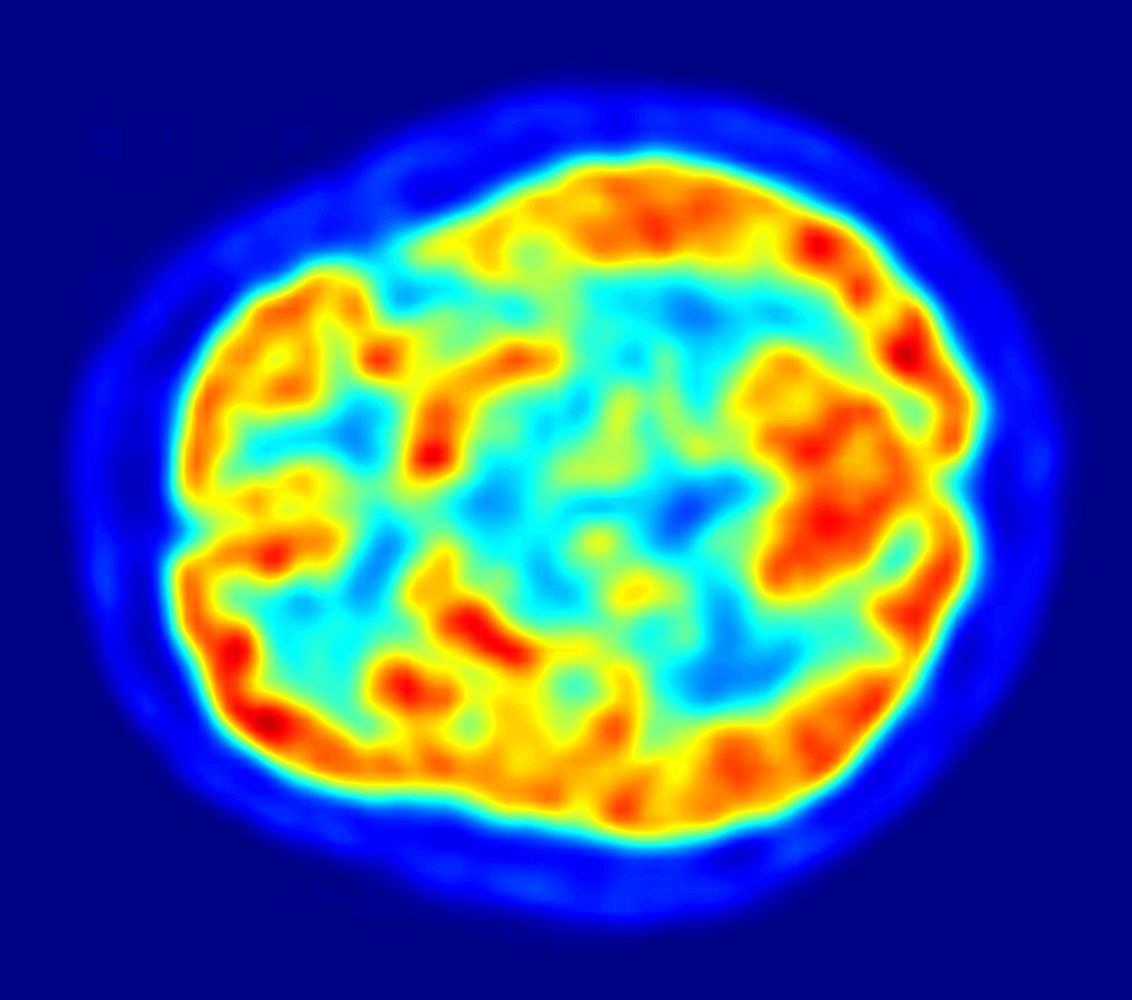

La estructura biológica de nuestros cerebros, sugiere la existencia de determinados procesos a niveles cuánticos, al igual que se da en otros procesos biológicos o químicos. Aunque es una cuestión sujeta a polémica, se acepta generalmente la naturaleza esencialmente no determinista de los niveles cuánticos; nuestra percepción de un universo determinista se basa en que nuestros sentidos operan sólo a niveles “clásicos” (es decir, los explicados por la física clásica); aunque no son bien conocidos los mecanismos de transición del mundo cuántico al mundo clásico (por ejemplo, procesos de decoherencia o pérdida del entrelazamiento) si parece claro que el dominio de la bioquímica no parece muy compatible con el determinismo absoluto que rige en el mundo de las máquinas de Turing.

La imagen PET del cerebro humano mostrando el consumo de energía (Fuente Wikipedia)

Por último, si consideramos las tesis lingüísticas de Noam Chomsky, una de las características comunes a todas las lenguas naturales es su capacidad de recursividad; la recursividad es aplicable tanto a procesos como a estructuras lingüísticas y, aunque en la práctica se maneja un número finito de niveles, no hay límite para el número de niveles. Este hecho, junto a la plasticidad en la elaboración de conceptos, dota a las lenguas naturales de una capacidad de evolución y creación de la que carecen los lenguajes formales que se emplean en la programación de computadoras.

En resumen, no parece plausible que el ser humano se pueda caracterizar como una máquina algorítmica, ni tampoco parece que las máquinas basadas en algoritmos puedan ir más allá de ser nuestras nuevas herramientas , eso sí, mucho más sofisticadas y con implicaciones de gran alcance para nuestros modelos políticos, económicos y sociales.

¿Qué debemos temer de la inteligencia artificial?

Como en toda nueva tecnología, debemos temer los usos inadecuados y perversos de la misma, así como dar la bienvenida a los usos que permiten mejorar la calidad de vida de la humanidad. Una reflexión sobre la revolución digital nos lleva a pensar que la mayor amenaza de la misma es la que se cierne sobre nuestra libertad. En efecto, nuestra tesis es que está emergiendo una dimensión digital , de carácter global, donde todas las personas estarán conectadas, y que sirve para articular los procesos de naturaleza social y económica. Vemos cómo las barreras a la competencia se difuminan, pudiéndose conjeturar en el futuro un mundo donde la competencia sea de carácter global. También vemos aparecer nuevos fenómenos de manipulación de las masas, como es el caso del conocido como posverdad.

Este fenómeno complejo no es meramente un sinónimo sofisticado de la mentira, conlleva la tesis de que no existe una verdad sino múltiples verdades que compiten para establecer sus esferas de influencia. Sospechamos que detrás de estos fenómenos hay una estrategia de dominación global basada en la imposición de un pensamiento único, que se manifiesta en múltiples posverdades que nos den una ficción de libertad; esta dinámica estaría manejada desde una nueva élite global que se sustrae al control de los mecanismos democráticos, y que competiría entre sí para maximizar sus esferas privadas de influencia.

La pérdida de la sacralidad del hombre, mediante su igualación con las máquinas y con los animales, podría formar parte del núcleo del pensamiento único que hemos comentado. En este contexto, se podría aspirar a delegar en las máquinas determinados procesos utilizando criterios de racionalidad y eficiencia, y eliminando barreras éticas tradicionales en nombre de la pluralidad que exige un mundo donde rige la posverdad. Esto, indefectiblemente, se traduciría en una nueva forma de esclavitud, eso sí, extremadamente sofisticada, pues contaría con el concurso entusiasta de una gran mayoría de los nuevos esclavos.